اولین قدم در هر استراتژی کامل سئو، بهبود وضعیت سئو تکنیکال شماست. اطمینان از اینکه وب سایت شما در بهترین شکل است به ترافیک ارگانیک، رتبه بندی کلمات کلیدی و تبدیل بیشتر کمک می کند.

آیا می دانید سئو تکنیکال دقیقاً چیست؟ برای اطلاع کامل از اصول سئو تکنیکال میتوانید به مقالهای که پیشتر در راشوب منتشر کردهایم سری بزنید. مهم نیست که برند یا شرکت شما در چه صنعتی فعالیت میکند، اصول سئو تکنیکال همیشه از مهم ترین بخش های کار است. در ادامه این مقاله قصد داریم که به طور خلاصه به مهمترین نکات سئو تکنیکال بپردازیم، با ما همراه باشید.

برای دانلود نسخه PDF کلیک کنید؛ تعداد کلمات ۱۳۴۰ کلمه، زمان تقریبی مطالعه ۶ دقیقه.

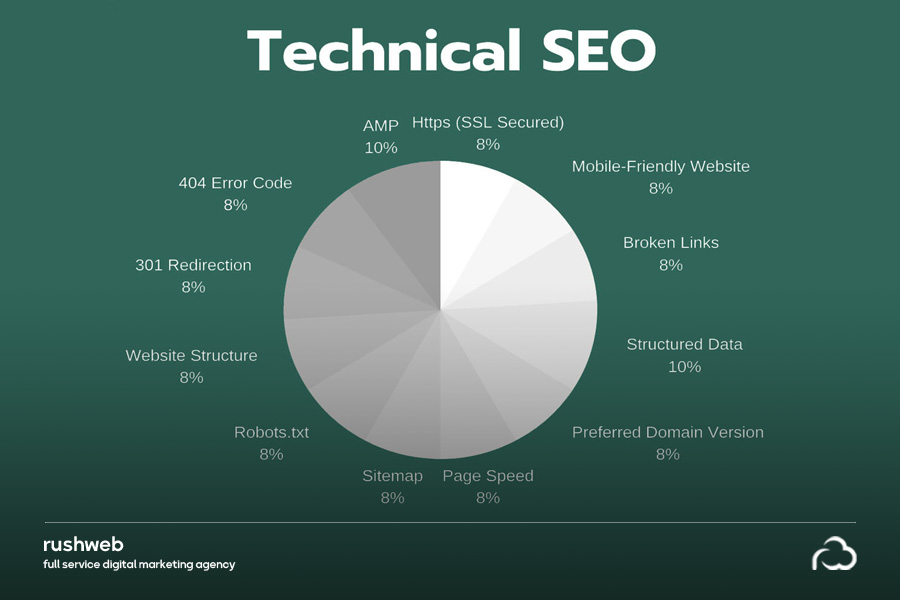

نکات سئو تکنیکال

۱. تجربه صفحه خود را به روز کنید – معیارهای اصلی

الگوریتمهای گوگل به تازگی سیگنالهای مثبت موجود از یک وبسایت را با سیگنالهای تجربه صفحه جدید Core Web Vitals ترکیب میکنند، از جمله سازگاری با تلفن همراه، مرور ایمن، پروتکل HTTPS، و دستورالعملهای بینابینی مزاحم.

اگر راجب Core Web Vitals Google اطلاع ندارید؛ بهتر است بدانید که از سه عامل تشکیل شده است:

تاخیر ورودی اول (FID): FID زمانی را اندازه گیری می کند که شخصی می تواند برای اولین بار با صفحه تعامل داشته باشد. برای اطمینان از تجربه کاربری خوب، صفحه باید FID کمتر از 100 میلی ثانیه داشته باشد.

بزرگترین رنگ محتوایی (LCP): LCP عملکرد بارگیری بزرگترین عنصر محتوا را روی صفحه اندازهگیری می کند. این باید در عرض 2.5 ثانیه اتفاق بیفتد تا یک تجربه کاربری خوب ارائه شود.

تغییر چیدمان تجمعی (CLS): ثبات بصری عناصر روی صفحه را اندازهگیری میکند. سایت ها باید تلاش کنند تا صفحات خود CLS کمتر از 0.1 ثانیه داشته باشند.

این عوامل رتبهبندی را میتوان در گزارشی که در کنسول جستجوی گوگل یافت میشود اندازهگیری کرد، که به شما نشان میدهد کدام URLها دارای مشکلات بالقوه هستند.

ابزارهای زیادی وجود دارد که به شما در بهبود سرعت سایت و Core Web Vitals کمک می کند، از جمله Google PageSpeed Insights ،Lighthouse و Webpagetest.org.

برخی از بهینه سازی هایی که می توانید انجام دهید عبارتند از:

- اجرای بارگذاری تنبل (lazy-loading) برای تصاویر غیر حیاتی

- بهینهسازی فرمتهای تصویر برای مرورگر

- بهبود عملکرد جاوا اسکریپت

۲. سایت خود را بازنگری کنید و به دنبال انواع crawl errors باشید

باید مطمئن شوید که سایت شما عاری از هرگونه crawl errors است. خطاهای Crawl زمانی رخ می دهد که یک موتور جستجو سعی می کند به صفحهای در وب سایت شما برسد اما موفق نمی شود. میتوانید از Screaming Frog، Deep Crawl، SeoClarity استفاده کنید – ابزارهای زیادی برای انجام این کار به شما کمک میکنند. پس از جستوجو در سایت، به دنبال هر گونه crawl errors باشید. همچنین می توانید این موضوع را با کنسول جستجوی گوگل بررسی کنید.

الف) همه ریدایرکت ها را با ریدایرکت 301 به درستی اجرا کنید.

ب) صفحات خطای 4xx و 5 xx را مرور کنید تا متوجه شوید که می خواهید آنها را به کجا هدایت کنید.

نکته کاربردی: برای ارتقای سطح بعدی، باید مراقب مواردی از زنجیرهها یا حلقههای تغییر مسیر باشید، جایی که URLها چندین بار به URL دیگری هدایت میشوند.

۳. لینک های داخلی و خارجی شکسته را رفع کنید

ساختار ضعیف لینکها میتواند باعث تجربه کاربری ضعیف هم برای انسانها و هم برای موتورهای جستجو شود. زمانی که افراد روی لینکی در وبسایت شما کلیک می کنند و متوجه می شوند که آنها را به URL صحیح – یا کارآمد – نمی برد، باعث نارضایتی از سایت میشود.

باید مطمئن شوید که چند فاکتور مختلف را بررسی کرده اید:

- لینک هایی که توسط ریدایرکت 301 یا 302 به صفحه دیگری هدایت میشوند

- لینک هایی که به صفحه خطای 4XX میروند

- صفحه هایی که اصلاً به آنها لینک داده نمیشود

- یک ساختار لینک داخلی که خیلی عمیق است

برای رفع لینکهای خراب، باید URL مورد نظر را به روز کنید یا اگر دیگر لینکی وجود ندارد، آن را به طور کامل حذف کنید.

۴. از شر هرگونه محتوای تکراری خلاص شوید

مطمئن شوید که محتوای تکراری در سایت شما وجود نداشته باشد. محتوای تکراری می تواند ناشی از عوامل زیادی باشد، از جمله تکرار صفحه از پیمایش وجهی، داشتن چندین نسخه زنده سایت و محتوای دستکاری شده یا کپی شده. مهم است که به گوگل اجازه دهید فقط یک نسخه از سایت شما را لیست کند.

رفع محتوای تکراری را می توان به روش های زیر اجرا کرد:

راه اندازی 301 تغییر مسیرها به نسخه اصلURL . بنابراین اگر نسخه ترجیحی شما https://www.abc.com است، سه نسخه دیگر باید 301 مستقیماً به آن نسخه هدایت شوند.

- پیادهسازی تگهای بدون فهرست یا متعارف در صفحات تکراری

- تنظیم دامنه ترجیحی در کنسول جستجوی گوگل

- تنظیم کنترل پارامترها در کنسول جستجوی گوگل

- در صورت امکان، هر گونه محتوای تکراری را حذف کنید

۵. سایت خود را به پروتکل HTTPS منتقل کنید

در سال 2014، گوگل اعلام کرد که پروتکل HTTPS یک عامل رتبهبندی است. بنابراین، در سال 2022، اگر سایت شما هنوز HTTP است، زمان آن رسیده است که آنرا تغییر دهید.

HTTPS از دادههای بازدیدکنندگان شما محافظت میکند تا اطمینان حاصل کند که دادههای ارائه شده رمزگذاری شده است تا از هک یا نشت دادهها جلوگیری شود.

۶. مطمئن شوید که URL های شما ساختار مرتبی دارند

طبق گفته گوگل “ساختار URL سایت باید تا حد امکان ساده باشد.”

URLهای بیش از حد پیچیده می توانند با ایجاد تعداد آدرسهای غیر ضروری اینترنتی که به محتوای یکسان یا مشابه در سایت شما اشاره میکنند، برای جستوجو کنندگان مشکل ایجاد کنند. در نتیجه خزندههای گوگل ممکن است نتواند تمام محتوای سایت شما را ایندکس کند.

در اینجا چند نمونه از URL های مشکل دار آورده شده است:

- الگوریتم جستجو در برخی از سایتهای بزرگ فروشگاهی سبب میشود تا یک آدرس URL بلند برای نتایج جستجو ظاهر شود که میتواند میزان زمان بررسی آدرس را توسط خزندههای گوگل افزایش دهد. مانند:

http://www.example.com/results?search_type=search_videos&search_query=tpb&search_sort=relevance&search_category=25 - پارامترهای نامربوط در URL، مانند پارامترهای ارجاع

http://www.example.com/search/noheaders?click=6EE2BF1AF6A3D705D5561B7C3564D9C2&clickPage=OPD+Product+Page&cat=79

۷. مطمئن شوید که سایت شما دارای نقشه سایت بهینه شده است

نقشههای سایت به موتورهای جستجو در مورد ساختار سایت شما و آنچه را که نیاز است تا ایندکس شود را ارائه میکنند.

یک نقشه سایت بهینه شده باید شامل موارد زیر باشد:

- هر محتوای جدیدی که به سایت شما اضافه می شود (پست های اخیر وبلاگ، محصولات و غیره).

- اگر سایت شما بیش از 50000 URL داشته باشد باید چندین نقشه سایت داشته باشید تا بودجه کرول خود را به حداکثر برسانید.

همچنین شما باید موارد زیر را از نقشه سایت XML حذف کنید

- آدرس های اینترنتی که شامل پارامترها هستند

- URLهایی که توسط ریدایرکت 301 در حال تغییر مسیر هستند یا حاوی تگهای No-index یا بدون فهرست هستند

- نشانیهای اینترنتی با کدهای وضعیت 4xx یا 5xx

- محتوای تکراری

میتوانید گزارش پوشش index مطالب را در کنسول جستجوی Google بررسی کنید تا ببینید آیا در نقشه سایت شما خطایی وجود دارد یا خیر.

۸. مطمئن شوید که سایت شما یک فایل robots.txt بهینه شده دارد

فایلهای Robots.txt دستورالعملهایی برای رباتهای موتورهای جستجو در مورد نحوه خزیدن وبسایت شما هستند. هر وبسایتی دارای «بودجه خزش» یا تعداد محدودی از صفحات است که میتوانند در خزیدن گنجانده شوند – بنابراین ضروری است مطمئن شوید که فقط مهمترین صفحات شما ایندکس میشوند.

از طرف دیگر، باید مطمئن شوید که فایل robots.txt شما چیزی را که قطعاً میخواهید ایندکس شود، مسدود نمیکند.

در اینجا چند URL نمونه وجود دارد که نباید آنها را در فایل robots.txt خود مجاز کنید:

- فایل های موقت

- صفحات مدیریت

- صفحات سبد خرید و پرداخت

- صفحات مرتبط با جستجو

- URLهایی که حاوی پارامتر هستند

در نهایت، باید مکان نقشه سایت را در فایل robots.txt قرار دهید. میتوانید از آزمایشکننده Google robots.txt برای تأیید صحت کارکرد فایلتان استفاده کنید.

۹. داده های ساخت یافته یا نشانه گذاری اسکیما را اضافه کنید

داده های ساختاریافته به ارائه اطلاعات در مورد یک صفحه و محتوای آن کمک می کند. به گوگل در مورد معنای صفحه کمک می کند و به لیست های ارگانیک شما کمک می کند تا در SERP ها برجسته شوند. یکی از رایج ترین انواع دادههای ساخت یافته، نشانهگذاری اسکیما نام دارد. انواع مختلفی از نشانهگذاریهای اسکیما برای ساختاردهی دادهها برای افراد، مکانها، سازمانها، کسبوکارهای محلی، بررسیها و موارد دیگر وجود دارد.

میتوانید از مولدهای نشانهگذاری اسکیما آنلاین، مانند این مورد از Merkle، و ابزار تست دادههای ساختاریافته Google برای کمک به ایجاد نشانهگذاری اسکیما برای وبسایت خود استفاده کنید.

همچنین بخوانید: